Selbstfahrende Autos sollen schneller reagieren können als der Mensch. Es gab jedoch bereits Schlagzeilen über selbstfahrende Fahrzeuge, bei denen die Technik doch nicht so perfekt funktionierte, weshalb es teilweise zu tödlichen Unfällen kam. Forscher des Max-Planck-Instituts für Intelligente Systeme (MPI-IS) in Tübingen haben jetzt herausgefunden, dass schon kleinste Farbflecken und Muster den Autopiloten derart durcheinander bringen könnten, dass die Fahrzeuge möglicherweise zu einem echten Sicherheitsrisiko werden. Noch sind die Erkenntnisse der Wissenschaftler nur Mutmaßungen, weil von den einzelnen Autoherstellern nicht veröffentlicht wird, wie ihre selbstfahrenden Autos genau funktionieren. Das Ergebnis der Arbeit ist trotzdem alarmierend.

Wie autonome Fahrzeuge funktionieren

Die an den selbstfahrenden Autos angebrachten Kameras liefern Daten der Umgebung. Ein System wertet sie aus und interpretiert sie. So sollte - vereinfacht gesagt - ein selbstfahrendes Auto funktionieren. Wie dieses Zusammenspiel im Detail funktioniert, ist ein wohlgehütetes Geheimnis der jeweiligen Hersteller.

Bewegung in einer Szene wird falsch interpretiert

Dass bei der Datenübertragung Objekte wie zum Beispiel Stoppschilder falsch klassifiziert werden, konnten Forscher bereits mehrmals in der Vergangenheit belegen. Die Tübinger Forscher um Anurag Ranjan konnten jetzt erstmals nachweisen, dass das System bei einer Störung die Bewegung in einer Szene falsch interpretiert. Um eine solche Störung herbeizuführen, reicht bereits ein kleiner Fleck in einer Größe von weniger als ein Prozent des Gesamtbildes aus. Die Folgen sind fatal: Der Bordcomputer geht von falschen Tatsachen aus. Nach seiner Berechnung bewegen sich die Gegenstände in entgegengesetzter Richtung als in Wirklichkeit. Das passiert selbst dann, wenn sich das Farbmuster nicht bewegt. Grundsätzlich gilt: Je größer der Fleck, desto verheerender die Auswirkungen.

Auch Hacker haben leichtes Spiel

Auch Hacker könnten aufgrund dieser Störanfälligkeit Autos leicht manipulieren, wie die Tübinger Forscher nachweisen konnten.

„Wir haben drei, vielleicht vier Stunden gebraucht, um das Muster zu erstellen – das ging ganz schnell.“ Anurag Ranjan, Doktorand in der Abteilung für Perzeptive Systeme am Max-Planck-Institut für Intelligente Systeme (MPI-IS) in Tübingen.

Im Klartext bedeutet das: Ein Farbmuster auf einem T-Shirt, als Heckscheibenaufkleber oder als Emblem auf einer Einkaufstüte könnte für selbstfahrende Autos ein Problem darstellen.

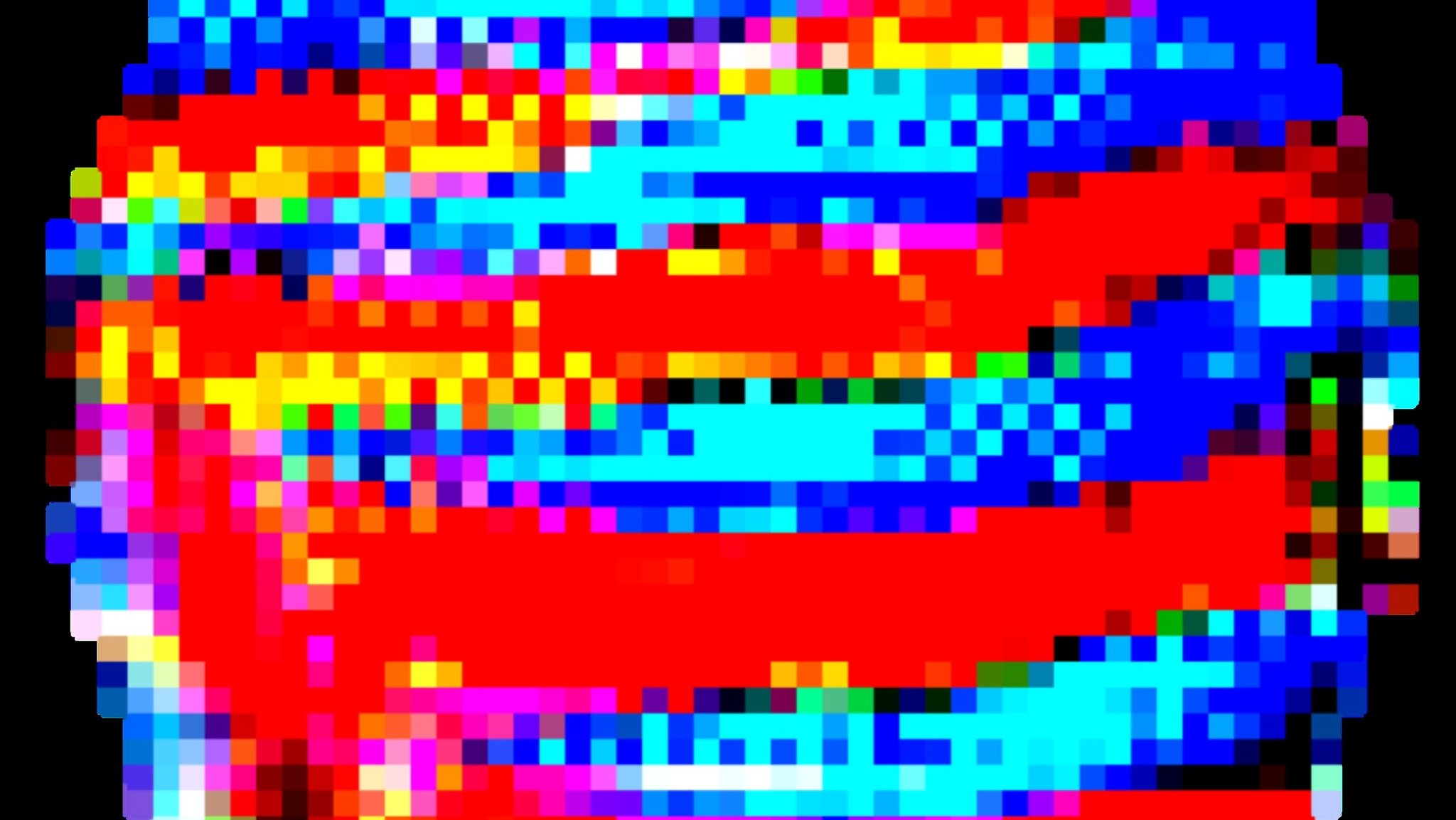

Selbstfahrende Autos lassen sich durch Farbmuster verwirren.

Ziel der Forscher: Autohersteller über Risiken informieren

Die Forscher haben ein klares Ziel:

"Unsere Arbeit soll die Hersteller von selbstfahrender Technologie wachrütteln, sie vor der potenziellen Bedrohung warnen. Wenn sie davon wissen, können sie ihre Systeme so trainieren, dass sie gegenüber derartigen Angriffen robust sind.“ Michael J. Black, Direktor der Abteilung für Perzeptive Systeme am Max-Planck-Institut für Intelligente Systeme (MPI-IS) in Tübingen

Sie haben deshalb Firmen wie Tesla, Porsche, Daimler, BMW und Bosch über das mögliche Risiko informiert.

Autonome Fahrzeuge: "Von Serieneinführung noch weit entfernt"

"Beim Thema automatisiertes Fahren sind wir noch unglaublich weit von der generellen Straßentauglichkeit und einer Serieneinführung in einem anspruchsvollen Umfeld entfernt" Eric Sax, Wissenschaftler am Karlsruher Institut für Technologie (KIT), der selbst nicht an der Studie beteiligt war.

Einen Trost gibt es aber: Die Gefahr, dass aktuell auf dem Markt verfügbare Serienfahrzeuge betroffen sind, sei gering, heißt es in der Pressemitteilung des MPI-IS in Tübingen.

Mit diesem Farbmuster konnten die Forscher des Max-Planck-Instituts in Tübingen ein selbstfahrendes Fahrzeug durcheinanderbringen.