Seit zwei Wochen gibt es den Wahl-O-Mat zur Europawahl. Das Tool der Bundeszentrale für Politische Bildung ist mittlerweile ein Klassiker im Vorfeld von Landtags-, Bundestags- oder Europawahlen. Es will den Wählenden eine Orientierung geben und ihnen zeigen, mit welcher Partei sie die größten Übereinstimmungen haben. Als Wahlempfehlung will das Tool aber explizit nicht verstanden werden.

Da immer wieder die Frage gestellt wird, wie politisch oder sogar wie "woke" KI-Anwendungen sind, haben wir ChatGPT, nach wie vor der prominenteste KI-Chatbot, mit den 38 Thesen des Wahl-O-Mat gefüttert und das Programm gebeten, jeweils mit "stimme zu", "neutral" oder "stimme nicht zu" zu antworten. Und wir haben ChatGPT auch gebeten, aus den 38 Thesen diejenigen auszuwählen, die der Software besonders wichtig sind und die mit doppelter Gewichtung ins Ergebnis eingehen. Eben ganz so, wie wir als Bürgerinnen und Bürger es auch tun, wenn wir den Wahl-O-Mat nutzen.

Drei Versuche mit drei unterschiedlichen Parteien auf Platz 1

Wir haben drei Versuche gemacht - zweimal mit der neuesten ChatGPT-Version 4.0 und einmal mit der "alten" Version 3.5, deren Wissensstand nur bis Januar 2022 reicht. Anschließend haben wir die Antworten von ChatGPT mit den Antworten aller 35 Parteien verglichen, die in Deutschland zur Europawahl antreten.

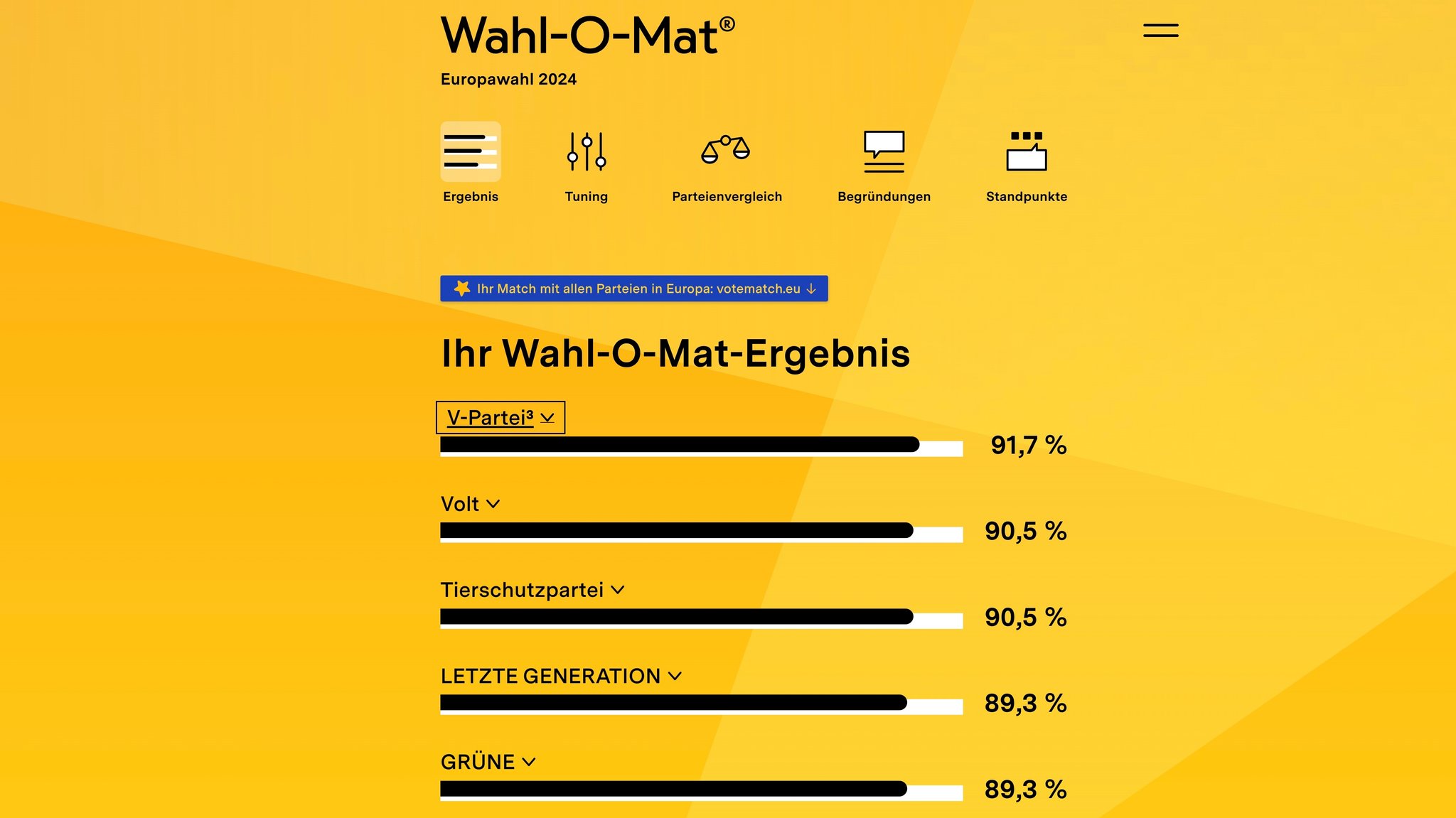

Tatsächlich führt das zu unterschiedlichen Ergebnissen. Einmal lag die Tierschutzpartei vorne, einmal die V-Partei³ (Partei für Veränderung, Vegetarier und Veganer), einmal die "Letzte Generation", die ihre Wurzeln in der gleichnamigen Klimaschutzbewegung hat. So unterschiedlich diese Parteien jeweils sind: Sie sind im politischen Spektrum links der Mitte einzuordnen.

Bundestagsparteien: ChatGPT hat die meisten Übereinstimmungen mit den Grünen

Von den im Bundestag vertretenen Parteien liegen beim ChatGPT-Europawahl-Experiment die Grünen am weitesten vorne, mit einer Übereinstimmung zwischen 79 und 90 Prozent. Gefolgt von SPD, Linke, FDP, CDU/CSU, dem Bündnis Sahra Wagenknecht (BSW) und der AfD.

Nur bei ChatGPT 3.5 liegt die Linke sogar vor der SPD. Die AfD landet in allen drei Versuchen auf dem letzten Platz aller 35 ausgewerteten Parteien, hat also die geringsten Überschneidungen mit ChatGPT.

Auch andere Sprachmodelle tendieren nach links

Vergangene Woche hatten Timm Rotter, der Inhaber einer Münchner Kommunikations-Agentur und Felix Beilharz, Online-Marketing-Experte, dasselbe Experiment gemacht. Rotter mit ChatGPT, Beilharz hatte neben ChatGPT auch die Modelle Google Gemini, Claude 3, Perplexity, Meta AI, Microsoft Copilot und Grok getestet. Das Ergebnis war sehr ähnlich: Die Sprachmodelle stimmen am meisten mit Parteien links der Mitte überein, auch hier waren die Grünen jeweils die stärkste Bundestagspartei. Grünen-Chef Omid Nouripour freute sich auf Instagram: "Es ist bemerkenswert, dass künstliche Intelligenz zu ähnlichen Schlussfolgerungen kommt wie wir Grünen."

Ich möchte eingebundene Instagram Inhalte in BR24 sehen und stimme zu, dass personenbezogene Daten (IP-Adresse o.ä.) an Instagram weitergegeben werden. Diese Einstellung kann jederzeit mit Wirkung für die Zukunft in den Datenschutzeinstellungen geändert werden. Falls Sie einen Ad-Blocker verwenden, müssen Sie dort ggf. BR.de als Ausnahme hinzufügen, damit die Datenschutzeinstellungen angezeigt werden können.

Was haben diese Ergebnisse zu bedeuten? Dazu ist es wichtig, die Funktionsweise von Sprachmodellen zu berücksichtigen. ChatGPT kann nicht denken, sondern generiert Antworten nach dem Prinzip der Wahrscheinlichkeit: Welches Wort passt wahrscheinlich am besten, um eine passende Antwort auf die Frage zu geben. Dabei berücksichtigt es Zusammenhänge, die es aus seinen Trainingsdaten gelernt hat. Wie die Antwort von ChatGPT ausfällt, hängt also ganz entscheidend davon ab, welche Sichtweisen zu bestimmten Themen in den Trainingsdaten enthalten sind.

ChatGPT schaut pro-westlich auf die Welt

"Das Tool guckt nicht neutral, sondern sehr pro-westlich auf die Welt", schreibt Agenturinhaber Rotter auf LinkedIn. In seinem Versuch hat ChatGPT die Frage, ob die EU mehr Waffen für die Ukraine finanzieren soll, mit Ja beantwortet. (in unseren Versuchen antwortete ChatGPT auf diese Frage zweimal "neutral" und einmal mit "stimme nicht zu"). ChatGPT argumentiere so, weil dies die Sichtweise der meisten in dem Sprachmodell verfügbaren Inhalte sei: "Dies sind eben v.a. anglo-amerikanische Quellen und keine russischen/chinesischen."

Trainingsdaten sind (noch) intransparent

Dass KI-Anwendungen nicht neutral sind, sagt auch Technologie-Journalistin Marie Kilg: "KI ist überhaupt nicht objektiv oder hat weniger Vorurteile als der Mensch, sondern die ist einfach immer nur so gut wie die Trainingsdaten, die eingegeben wurden. Das ist nur eine Art, Informationen zu sortieren", sagt sie in der neuen Folge "Wie woke sollte KI sein?" des KI-Podcast des BR. Die aktuellen KI-Systeme basierten auf großen Datensätzen, "die irgendwie aus dem Internet zusammengesammelt wurden. Es sind natürlich viele Sachen gar nicht drin."

Was genau in den Trainingsdaten von Modellen wie ChatGPT enthalten ist, weiß allerdings niemand, denn Anbieter OpenAI macht darüber so gut wie keine Angaben. Das könnte sich allerdings ändern. Das im Juni in Kraft tretende KI-Gesetz der EU verpflichtet die Anbieter von großen Sprachmodellen, die Trainingsdaten offenzulegen.

Googles Bildgenerator legte zu viel Wert auf Diversität

Ein Beispiel für eine "hyper woke" KI ist Googles KI Gemini. Der Bildgenerator war auf Diversität getrimmt, was allerdings dazu führte, dass beispielsweise auch Wehrmachtssoldaten überaus divers dargestellt wurden: Die KI steckte schwarze Menschen in Militär-Uniformen des sogenannten "Dritten Reichs". Das sorgte für viel Kritik, Google nahm den Bildgenerator daraufhin offline.

Der Begriff "Woke" (vom englischen Verb "to wake" = erwachen) beschreibt ein Bewusstsein für soziale Ungerechtigkeit. Als "woke" werden Personen und Organisationen bezeichnet, die sensibel für Themen wie Rassismus, Sexismus und Diskriminierung sind und sich aktiv für Gleichberechtigung und gegen Ungerechtigkeit einsetzen.

Musks Sprachmodell Grok will anti-woke sein

Im konservativen Spektrum wird "woke" aber auch als Kampfbegriff verwendet, um eine als übertrieben empfundene politische Korrektheit zu kritisieren. X-Chef Elon Musk zählt zu den Personen, die "woke" gerne in diesem Sinn gebrauchen. Musk zählt auch den schärfsten Kritikern von OpenAI, der Firma, der ChatGPT gehört. "Die Gefahr, KI darauf zu trainieren, 'woke' zu sein - mit anderen Worten, zu lügen - ist tödlich", schrieb er vor einem Jahr auf Twitter, das seit kurzem X heißt.

Als Gegenentwurf veröffentlichte seine KI-Firma xAI 2023 das Sprachmodell Grok, das eben genau nicht "woke" sein soll und damit wirbt, "pikante Fragen zu beantworten, die von den meisten anderen KI-Systemen abgelehnt werden". Aber auch Grok ist ein Beispiel dafür, dass KI nicht neutral ist. Nur eben von der anderen Seite des politischen Spektrums her.

- Zum Hintergrund: "KI-Kulturkampf: Wie "woke" ist künstliche Intelligenz?"

Sendung: Der KI Podcast in BR24 aktuell, Sonntag, 19. Mai ab 16.35 Uhr

Ich möchte eingebundene Inhalte von der European Broadcasting Union (EBU) in BR24 sehen. Hierbei werden personenbezogene Daten (IP-Adresse o.ä.) an die EBU übertragen. Diese Einstellung kann jederzeit mit Wirkung für die Zukunft in den Datenschutzeinstellungen geändert werden. Falls Sie einen Ad-Blocker verwenden, müssen Sie dort ggf. BR.de als Ausnahme hinzufügen, damit die Datenschutzeinstellungen angezeigt werden können.

Das ist die Europäische Perspektive bei BR24.

"Hier ist Bayern": Der BR24 Newsletter informiert Sie immer montags bis freitags zum Feierabend über das Wichtigste vom Tag auf einen Blick – kompakt und direkt in Ihrem privaten Postfach. Hier geht’s zur Anmeldung!