"Der Preis für das Kennenlernen von KI - das wirkliche Kennenlernen von KI - sind mindestens drei schlaflose Nächte." Das schreibt der BWL-Professor und KI-Experte Ethan Mollick im Vorwort seines Buchs Co-Intelligence.

Nach ein paar Stunden mit generativen KI-Systemen werde einem irgendwann klar, dass Large Language Models (LLMs), die neue Form der KI, die Dienste wie ChatGPT antreibt, sich nicht so verhalte, wie man es von einem Computer gewohnt sei. Stattdessen verhalte sie sich eher wie ein Mensch: "Es dämmert dir, dass du es mit etwas Neuem, etwas Fremdem zu tun hast und dass sich die Dinge ändern werden. Du stellst fest, dass sich die Welt grundlegend verändert hat und dass dir niemand wirklich sagen kann, wie die Zukunft aussehen wird."

Schwer vorstellbar, dass solche Sätze in einem Handbuch zu Microsoft Excel stehen würden. Denn: klassische Software ist dafür gemacht, möglichst zuverlässig zu sein und hat ein klares Versprechen, was sie leisten kann und wofür sie gedacht ist. Excel, Photoshop, Gmail und Co wurden für einen bestimmten Zweck erfunden.

KI ist anders als bisherige Software

Generative KI hingegen ist anders. Immer wieder zeigt sich, dass die großen Modelle für Aufgaben eingesetzt werden können, für die sie nicht explizit programmiert wurden. Dies ist auch Thema in der aktuellen Folge von "Der KI-Podcast". Ein besonders eindrucksvolles Beispiel: Im vergangenen Jahr investierte der Finanzinformationsdienstleister Bloomberg über zehn Millionen Dollar und, um eine Experten-KI für Börsenvorhersagen auf Basis von GPT-3.5 zu erschaffen. Dabei nutzte das Unternehmen seine internen, nicht öffentlichen Finanzdaten, um das Modell zu trainieren und diesem einen Vorteil gegenüber normalen Chatbots zu geben.

Als jedoch OpenAI nur wenige Monate später GPT-4 veröffentlichte, war das neue Modell besser in sämtlichen Finanzfragen als das Modell von Bloomberg – obwohl es nicht explizit für derartige Aufgaben programmiert wurde.

Deepfake-Merkel erklärt Mathematik

Auch in vielen anderen Bereichen kann man beobachten, wie findige Nutzerinnen und Nutzer neue Anwendungsarten für generative KI entwickeln, auf die davor noch niemand gekommen ist – nicht einmal die Erfinder der Modelle selbst. Und sehr oft haben sie dabei ziemlich viel Spaß.

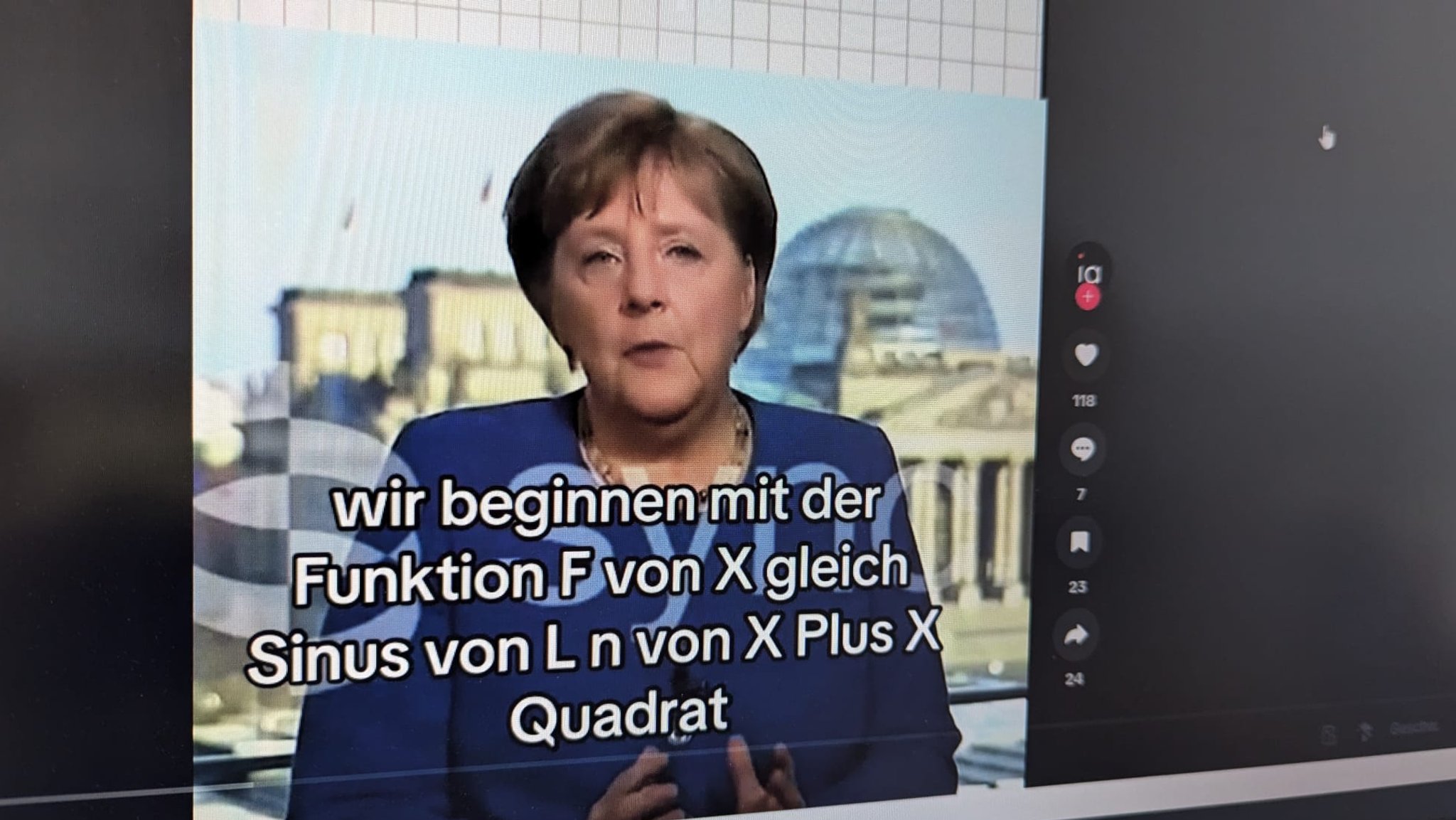

Ein Bereich, in dem gerade viel passiert, ist Bildung. Zahlreiche Nutzer experimentieren mit KI-Chatbots als Nachhilfelehrer beim Lernen von Sprachen, Programmieren oder Mathematik. Mit der zunehmenden Verfügbarkeit von Video-KIs kommt nun ein neues Genre der Bildungsvideos hinzu: Auf dem TikTok-Kanal "@sophiaedulabs" finden sich KI-Videos von Angela Merkel, Olaf Scholz oder dem Nationalspieler Florian Wirtz, in denen diese die Mitternachtsformel, Tangentialrechnung oder den Satz von Bayes erklären. KI-Deepfakes als Mathematik-Botschafter.

Spielerisches Entdecken neuer Anwendungen

Wie sehr derartige humorige Videos tatsächlich bei der Vorbereitung auf das Mathematik-Abi helfen können, wird kontrovers diskutiert. So kritisiert etwa der Informatiker Andrej Karpathy Bildungsangebote mit Entertainmentcharakter als zu oberflächlich. Festhalten lässt sich: KI bietet die Möglichkeit, abstrakte Themen auf eine lebendige Art zu vermitteln und dadurch Interesse und Begeisterung auszulösen, wo sonst vielleicht keine gewesen wäre.

Immer wieder zeigt sich also: wenn man sich beim Erkunden der Technologie KI von der Freude am Entdecken leiten lässt, findet man zahlreiche Anwendungsmöglichkeiten, die klassische Software bisher nicht geboten hat.

Ich möchte eingebundene Inhalte von der European Broadcasting Union (EBU) in BR24 sehen. Hierbei werden personenbezogene Daten (IP-Adresse o.ä.) an die EBU übertragen. Diese Einstellung kann jederzeit mit Wirkung für die Zukunft in den Datenschutzeinstellungen geändert werden. Falls Sie einen Ad-Blocker verwenden, müssen Sie dort ggf. BR.de als Ausnahme hinzufügen, damit die Datenschutzeinstellungen angezeigt werden können.

Das ist die Europäische Perspektive bei BR24.

"Hier ist Bayern": Der BR24 Newsletter informiert Sie immer montags bis freitags zum Feierabend über das Wichtigste vom Tag auf einen Blick – kompakt und direkt in Ihrem privaten Postfach. Hier geht’s zur Anmeldung!