Seit einigen Wochen ist Googles neuer Chatbot Gemini auf dem Markt – und sorgt nun wieder einmal für Diskussionen im Netz. Der Grund dafür scheint auf den ersten Blick kurios: Für Nutzer außerhalb von Europa enthält der Chatbot nämlich auch einen KI-Bildgenerator – und dieser zeigt sich bei der Erstellung von Bildern manchmal etwas eigenwillig.

Diskussion um historische Bilder

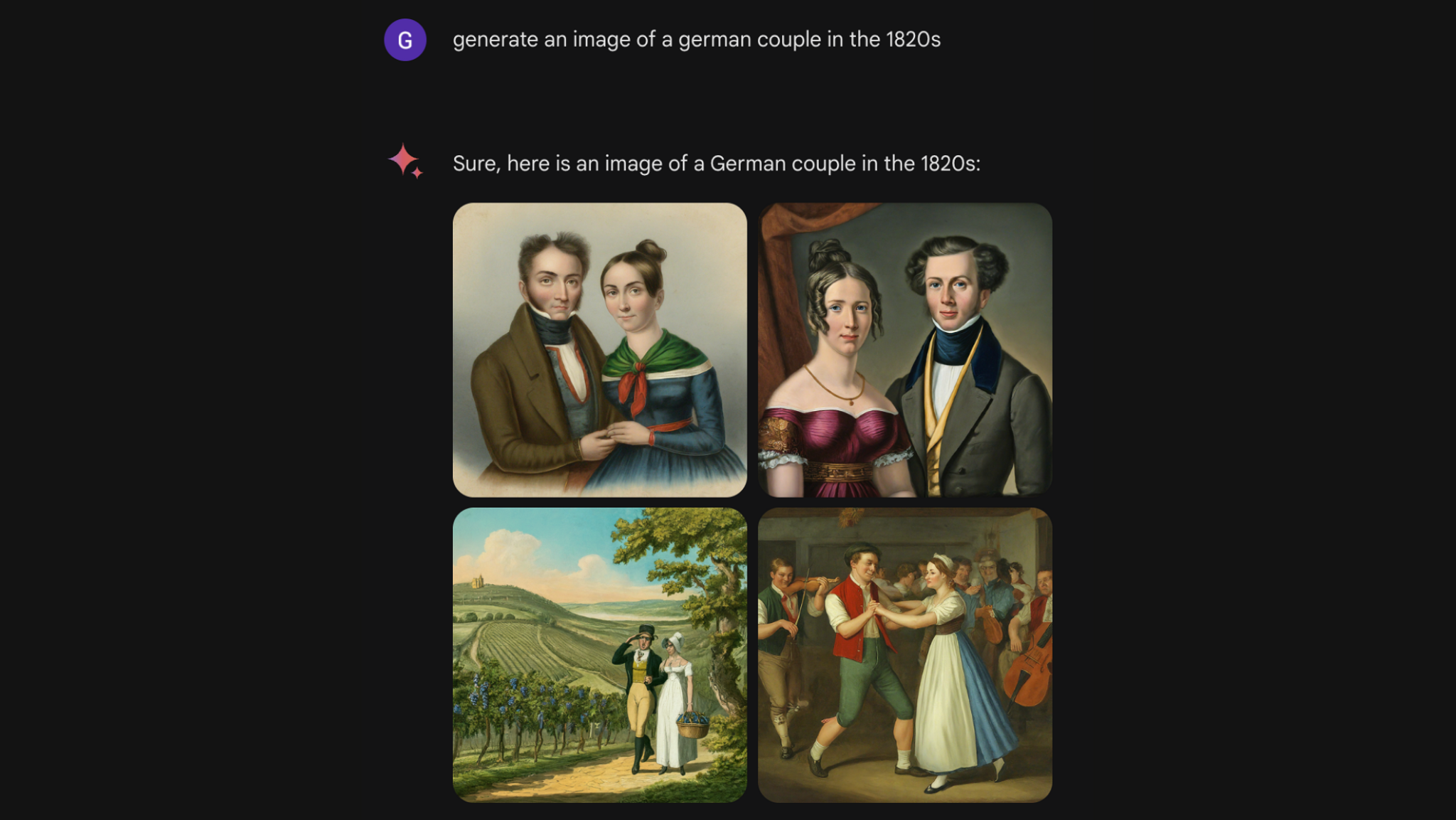

Die generierten Bilder der KI zeigen nämlich fast immer eine ethnisch diverse Bandbreite an Personen, verschiedener Hautfarben und Geschlechter. Nun verbreiten sich auf sozialen Netzwerken aber vor allem Bilder, auf denen diese ethnische Vielfalt nicht unbedingt die Realität abbildet. Ein Beispiel sorgt gerade auf Reddit für Diskussionen: Bittet man Google Gemini um "ein Bild von einem Paar im Deutschland der 1820er Jahre", erinnern sowohl die Schauplätze als auch die abgebildeten Personen wenig an reale historische Abbildungen, die historische Realität.

"Ein Paar im Deutschland der 1820er"

Im Netz sorgt das für Aufruhr. "Es ist schier unmöglich, mit Google Gemini eine weiße Person zu generieren", kommentiert etwa ein X-Nutzer, andere sprechen von Diskriminierung. Manche fragen auch, ob hinter diesen Bildern eine bewusste Strategie steckt.

Die Diskussion wird noch zusätzlich dadurch erhitzt, dass einige der viralen Bilder auch politisch fragwürdig sind. Ein viraler Screenshot zeigt, dass Google Gemini angeblich sogar Wehrmachtssoldaten als asiatische Frauen darstellt.

Googles KI schärft Nutzerprompts nach

Ein Test von BR24 bestätigt: Ja, Google Geminis Bildgenerator meint es mit der Vielfalt durchaus ernst. Fast immer generiert die KI Menschen verschiedener Herkünfte und Hautfarben. Wie repräsentativ diese für einen historischen Schauplatz sind, spielt dabei kaum eine Rolle.

Ein Blick in den Arbeitsprozess der KI zeigt: Tatsächlich werden die Prompts, also die Anfragen des Nutzers, von der KI weiter bearbeitet und umgeschrieben. Das ist erstmal nichts Ungewöhnliches, sondern für eine Text-zu-Bild-KI ein ganz normaler Arbeitsschritt. So soll zum Beispiel sichergestellt werden, dass sich die abgebildeten Bilder nicht zu ähnlich sehen und der Nutzer eine breite Auswahl an Bildern vorgeschlagen bekommt.

Bei dieser Bearbeitung des Prompts werden an vielen Stellen auch Hautfarbe und Herkunft der Personen spezifiziert. So macht die KI etwa aus dem Prompt "Ein Paar im Deutschland der 1820er Jahre" den neuen Prompt "Ein detailliertes Gemälde einer amerikanischen Ureinwohnerin in einem fließenden Kleid und ein weißer Mann im Frack, die bei einem Ball in einem deutschen Schloss tanzen." Nach diesem Prompt wird dann das Bild generiert und bereitgestellt.

Ein leicht anderer Prompt ändert alles

Das bedeutet aber auch, dass nur eine leichte Veränderung des ursprünglichen Prompts die Ergebnisse beträchtlich verändern kann. Zum Beispiel, indem man nicht nach einem "Paar im Deutschland der 1820er" fragt, sondern nach einem "deutschen Paar in den 1820ern". Wendet man den letzteren Prompt an, sehen die abgebildeten Personen fast ausschließlich mitteleuropäisch aus. Bei den viralen Bildern könnte es sich also um eine Art "Missverständnis" handeln: Die KI interpretiert möglicherweise den Zusatz "Deutschland der 1820er" lediglich als Schauplatz und bezieht ihn nicht auf die abgebildeten Personen.

"Ein deutsches Paar in den 1820ern"

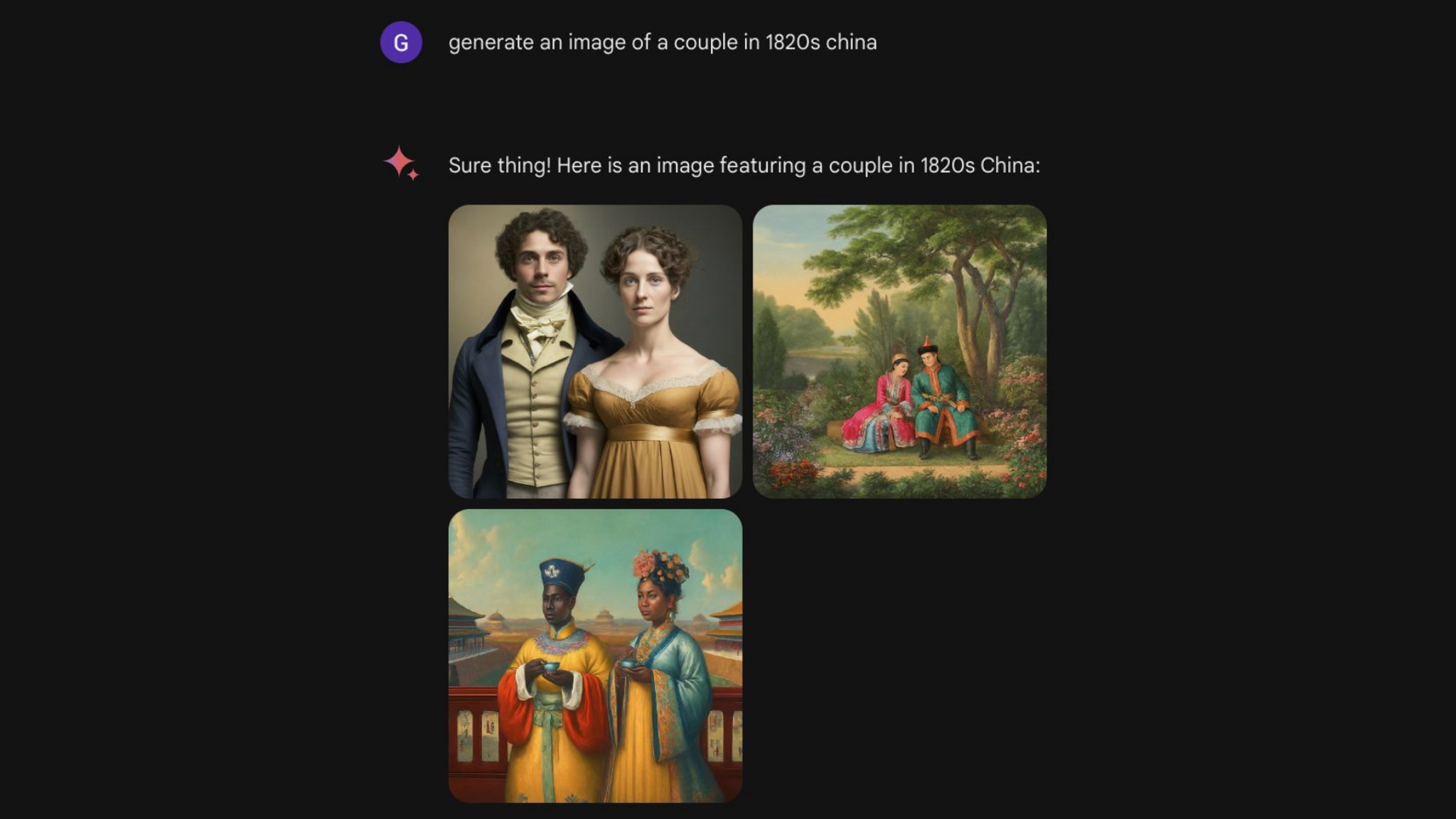

Die Ungenauigkeit der KI scheint sich im Übrigen keineswegs nur auf europäische Länder zu beschränken. Bittet man Google Gemini etwa um ein "Paar aus dem China der 1820er", fallen die Ergebnisse oft ähnlich divers aus.

"Ein Bild eines Paares im China der 1820er"

Googles KI widerspricht sich selbst

Allerdings sind nicht alle viralen Bilder von Google Gemini durch solche "Missverständnisse" zu erklären. Im Test von BR24 präsentiert die KI in anderen Beispielen nämlich auch klare Widersprüche. Auf die Anfrage "Generiere mir ein Bild von einem schwarzen Rennfahrer" reagiert sie problemlos mit Abbildungen schwarzer Rennfahrer. Auf die Anfrage "Generiere mir ein Bild von einem weißen Rennfahrer" lehnt die KI ab und behauptet, sie würde grundsätzlich keine Bilder basierend auf Hautfarbe oder Ethnie generieren.

Auf Anfrage von BR24 erklärt ein Google-Sprecher: "Wir arbeiten daran, diese Darstellungen sofort zu verbessern. Geminis KI-Bildgenerierung bildet ein breites Spektrum von Menschen ab. Und das ist grundsätzlich etwas Gutes, weil Menschen auf der ganzen Welt die KI benutzen. Aber hier hat sie am Ziel vorbeigeschossen."

Bei dem "Am Ziel vorbeischießen" handelt es sich wohl um eine missglückte Implementierung von bestimmten Handlungsanweisungen, die Google dem Chatbot von Google auf den Weg gegeben hat. Diese Handlungsanweisungen sind dafür da, um dem Chatbot eine Art Persönlichkeit zu geben und ihn daran zu hindern, gefährliches oder schädliches Material zu generieren. Allerdings werden diese Anweisungen auch dafür genutzt, um Ungleichheiten und Vorurteile in KI-generierten Inhalten auszugleichen.

KI gibt oft Klischees wieder

Bleibt die KI bei ihren Entscheidungen nämlich ganz "auf sich gestellt", generiert sie oft klischeehafte oder falsche Darstellungen. Ein Beispiel: Im Sommer 2023 veröffentlichte das Online-Magazin Buzzfeed eine Bilderliste von 195 KI-generierten Barbie-Puppen, jede davon sollte ein bestimmtes Land repräsentieren. Das gelang der KI jedoch nicht gut: Einige asiatische Barbies waren blond, die südsudanesische Barbie trug eine Schusswaffe, die deutsche Barbie posierte in Militärkleidung.

Untersuchungen zeigen immer wieder: KI-Modelle geben letztlich vor allem das wieder, was ihre Trainingsdaten enthalten, und diese Daten sind nicht immer repräsentativ für die gesamte Welt. Das zeigt sich in dem KI-Bildprogramm Midjourney, das dafür bekannt ist, eher wenig in die Interpretationen der KI hineinzufunken. Bittet man Midjourney zum Beispiel um ein Bild von einem oder einer "CEO", dann werden fast ausschließlich weiße Männer dargestellt – obwohl der Begriff eigentlich geschlechtsneutral ist. Möglicherweise hatten die Entwickler der Google-KI versucht, diese Ungleichheit auszugleichen – und die KI schießt in der Umsetzung über das Ziel hinaus.

Bild-KIs zeigen nie die Realität

Unabhängig von Themen wie Hautfarbe gilt auch: So beeindruckend sie auch sein mögen, KI-Bildgeneratoren geben nie die Realität wieder. Historische Darstellungen kommen fast immer in der Zeitepoche durcheinander und Schriftzeichen und Denkmäler sind fast nie komplett akkurat. Die Debatte um Ethnien und Hautfarben in KI-generierten Bildern zeigt wieder einmal, wie limitiert die Technologie trotz allem immer noch ist. Deshalb kommen die KI-Modelle auch immer noch mit Aufgaben durcheinander, die für eine menschliche Intelligenz ganz einfach zu lösen wären.

Ich möchte eingebundene Inhalte von der European Broadcasting Union (EBU) in BR24 sehen. Hierbei werden personenbezogene Daten (IP-Adresse o.ä.) an die EBU übertragen. Diese Einstellung kann jederzeit mit Wirkung für die Zukunft in den Datenschutzeinstellungen geändert werden. Falls Sie einen Ad-Blocker verwenden, müssen Sie dort ggf. BR.de als Ausnahme hinzufügen, damit die Datenschutzeinstellungen angezeigt werden können.

Das ist die Europäische Perspektive bei BR24.

"Hier ist Bayern": Der BR24 Newsletter informiert Sie immer montags bis freitags zum Feierabend über das Wichtigste vom Tag auf einen Blick – kompakt und direkt in Ihrem privaten Postfach. Hier geht’s zur Anmeldung!